O Google está no centro do comércio de inteligência artificial após o lançamento do seu novo modelo Gemini 3, que foi treinado nos próprios chips de IA da empresa, as Tensor Processing Units (TPUs). Este movimento ganha ainda mais força com a notícia de que a Meta Platforms estaria em negociações com o Google para adquirir esses chips, visando construir um data center de inteligência artificial que concorra diretamente com o domínio das GPUs da Nvidia. A Alphabet, empresa-mãe do Google, viu suas ações subirem 12% desde a estreia do Gemini 3 em 18 de novembro, enquanto as da Nvidia caíram 3,4%, destacando a crescente importância das TPUs no cenário tecnológico global.

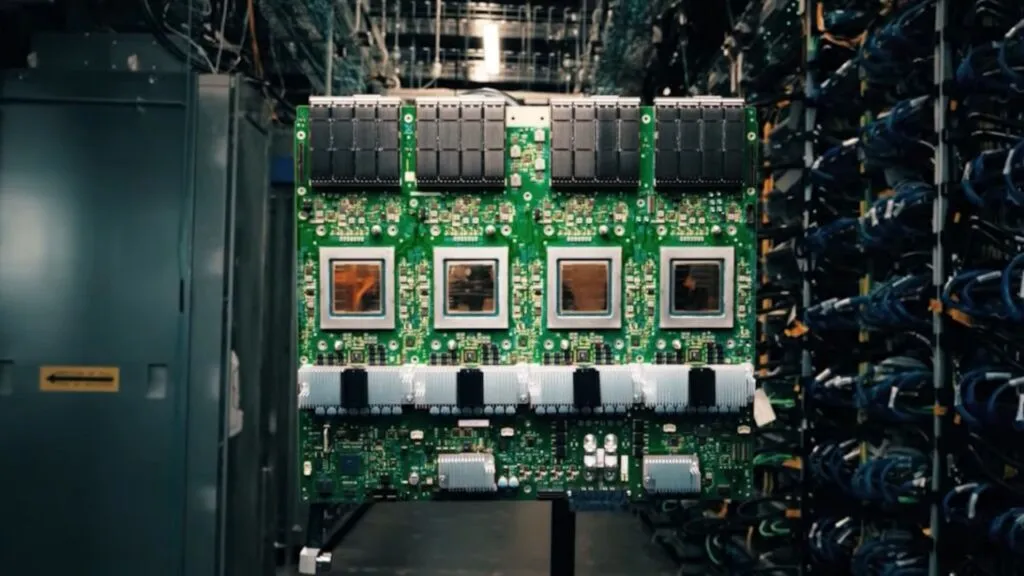

A busca por uma solução interna para o hardware de IA não é nova para o Google. Desde 2015, a empresa desenvolve as TPUs para alimentar seus próprios produtos, como Maps, Fotos e Tradutor. A necessidade de uma alternativa surgiu da dificuldade em obter grandes quantidades de hardware da Nvidia, que é caro e tem fornecimento limitado. Em 2025, o Google já está na sétima geração de suas TPUs, e agora, pela primeira vez, a empresa está encontrando clientes externos, como a Apple e a startup de IA Anthropic, que está avaliada em US$ 350 bilhões e tem um acordo de TPU como parte de sua estratégia multicloud.

Por Que o TPU do Google é uma Ameaça à Liderança da Nvidia?

A Nvidia, com sua arquitetura CUDA, domina o mercado de chips de data center, com mais de 80% de participação. No entanto, o sucesso do Gemini 3 e o interesse de grandes players como a Meta e a Anthropic nas TPUs do Google indicam uma mudança de cenário. As TPUs são projetadas especificamente para uma coisa: matemática de matriz para aprendizado profundo. Em condições ideais, elas podem oferecer uma estrutura de custos muito melhor do que as GPUs da Nvidia para cargas de trabalho de IA, como chatbots e assistentes de codificação.

A receita de data center da Nvidia aumentou 2.400% desde 2021, e a empresa alcançou uma margem de lucro bruto de 73% no terceiro trimestre. Esse sucesso, porém, cria uma dependência que os clientes preferem evitar. A escassez e o alto custo das GPUs da Nvidia, somados à sua alta margem de lucro, tornam as TPUs uma alternativa atraente. Além disso, outros grandes players de cloud, como Amazon Web Services (AWS) com o Trainium e Microsoft Azure, também estão investindo em seus próprios chips de IA, intensificando a concorrência.

Quando o Google Lançou a Primeira Geração de TPUs?

O Google lançou a primeira geração de suas Tensor Processing Units (TPUs) em 2015. Inicialmente, o hardware foi mantido em segredo e usado apenas internamente para acelerar tarefas de aprendizado de máquina em seus serviços. A decisão de desenvolver um chip próprio veio da necessidade de uma solução in-house para lidar com a escala de suas operações de IA, que já era um desafio para os servidores tradicionais e o hardware da Nvidia na época.

Quais Empresas de Destaque Estão Usando as TPUs Atualmente?

Além do próprio Google, que utiliza as TPUs para treinar e executar modelos como o Gemini 3, a startup de IA Anthropic é um dos clientes mais notáveis. A Anthropic, que é uma das principais concorrentes da OpenAI, tem um acordo de TPU como parte de sua estratégia multicloud. A Apple também treinou seus modelos de Apple Intelligence nas TPUs, mostrando que o chip do Google está se tornando uma alternativa viável e poderosa para as maiores empresas de tecnologia do mundo, que buscam reduzir sua dependência da Nvidia.

O futuro do mercado de chips de IA está se tornando cada vez mais competitivo. Embora a Nvidia ainda mantenha uma liderança forte, protegida em parte pelo seu ecossistema de software CUDA, o avanço das TPUs do Google e de outros chips customizados sinaliza uma era de maior diversidade e concorrência, o que pode beneficiar o desenvolvimento e a acessibilidade da inteligência artificial em escala global.

Link Interno: Google Ironwood TPU: o chip de IA 10x mais rápido que desafia a Nvidia

Fonte: MSN/Barron’s