A corrida pela supremacia em inteligência artificial (IA) ganhou um novo e surpreendente capítulo com o anúncio de um acordo de licenciamento de tecnologia entre a **Groq** e a Nvidia. Este movimento estratégico, que envolve a transferência de tecnologia de inferência de chips AI e a ida de executivos-chave da Groq para a Nvidia, redefine a dinâmica do mercado de hardware de IA. O acordo foca em expandir o acesso a soluções de inferência de alto desempenho e baixo custo, um ponto crucial para a adoção massiva de modelos de linguagem grandes (LLMs) no Brasil e no mundo.

O que o Licenciamento da Tecnologia Groq LPU significa para a Nvidia?

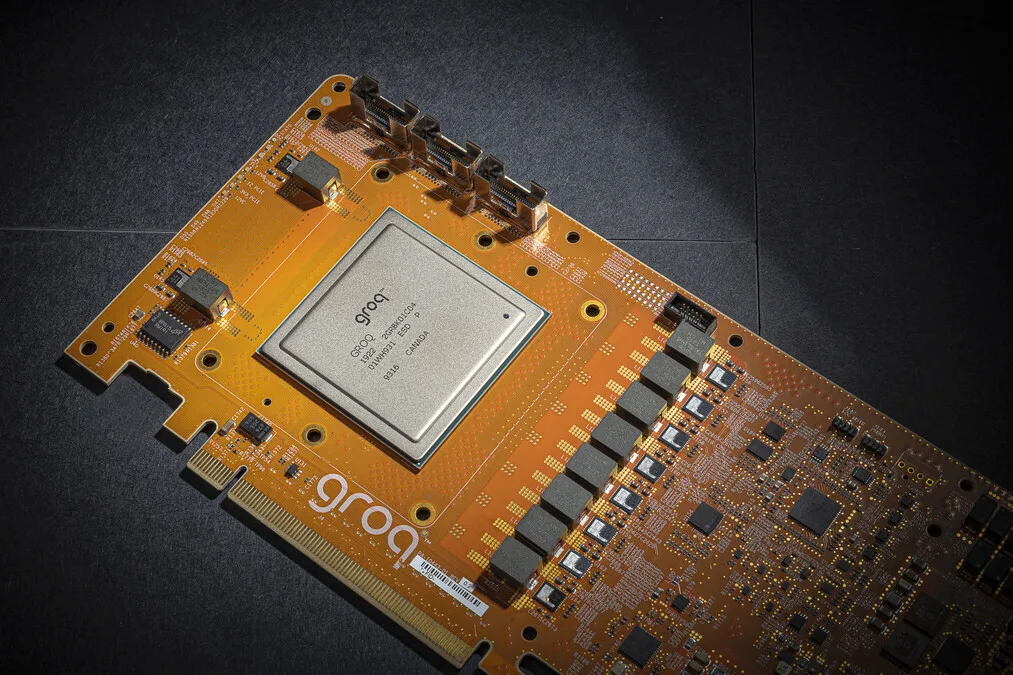

Diferente de uma aquisição completa, a Nvidia optou por licenciar a tecnologia de inferência da Groq, conhecida por sua Unidade de Processamento de Linguagem (LPU) que oferece velocidades de inferência significativamente mais rápidas que as GPUs tradicionais. A Groq continuará a operar como uma empresa independente, mas seu fundador, Jonathan Ross, e o presidente, Sunny Madra, juntamente com outros membros da equipe, passarão a integrar a Nvidia. Essa transferência de talentos e propriedade intelectual é um claro sinal do valor que a Nvidia atribui à inovação da Groq no campo da inferência de IA.

Para a Nvidia, líder incontestável no mercado de chips de treinamento de IA, o licenciamento da tecnologia da Groq representa uma forma de mitigar a ameaça competitiva e, ao mesmo tempo, incorporar uma solução de inferência de ponta ao seu portfólio. A tecnologia LPU da Groq é especializada em reduzir a latência, um fator crítico para aplicações de IA em tempo real, como chatbots avançados e assistentes virtuais. Com este acordo, a Nvidia fortalece sua posição em um segmento onde a Groq se destacava como uma alternativa promissora.

Como o acordo entre Groq e Nvidia impacta o mercado brasileiro de IA?

O Brasil, com seu crescente ecossistema de startups e empresas que buscam implementar soluções de IA, será diretamente beneficiado. A tecnologia de inferência mais rápida e potencialmente mais acessível pode acelerar a implantação de LLMs em português e a criação de serviços de IA com menor custo operacional. A promessa de “alto desempenho e baixo custo” é particularmente relevante para o mercado brasileiro, onde a otimização de recursos é fundamental para a competitividade.

A GroqCloud, plataforma de serviços de inferência da Groq, continuará a operar sem interrupções, garantindo que os clientes atuais e futuros, incluindo aqueles no Brasil, possam continuar a utilizar a tecnologia LPU. No entanto, a integração de talentos e a licença da tecnologia pela Nvidia sugere que, a longo prazo, as inovações da Groq podem ser incorporadas em produtos Nvidia, potencialmente democratizando ainda mais o acesso a chips de inferência de alta velocidade.

Próximos Passos e Perspectivas Futuras

A não-exclusividade do acordo de licenciamento é um detalhe importante. Isso significa que a Groq pode licenciar sua tecnologia para outras empresas, mantendo um certo grau de independência e competição no mercado. Contudo, a perda de executivos-chave para a Nvidia levanta questões sobre a direção futura da Groq como empresa de hardware. O novo CEO, Simon Edwards, terá o desafio de manter a Groq na vanguarda da inovação em chips de IA, mesmo com a saída de seu fundador.

Este acordo é um marco que sublinha a importância da inferência de IA e a busca por soluções que tornem os modelos de IA mais rápidos e eficientes. Para os desenvolvedores e empresas brasileiras, a expectativa é de que a competição e a inovação resultantes deste movimento tragam benefícios tangíveis em termos de performance e custo para suas aplicações de inteligência artificial. Para mais detalhes sobre a tecnologia LPU, consulte o site oficial da Groq. A Nvidia também publicou um comunicado em sua sala de imprensa.