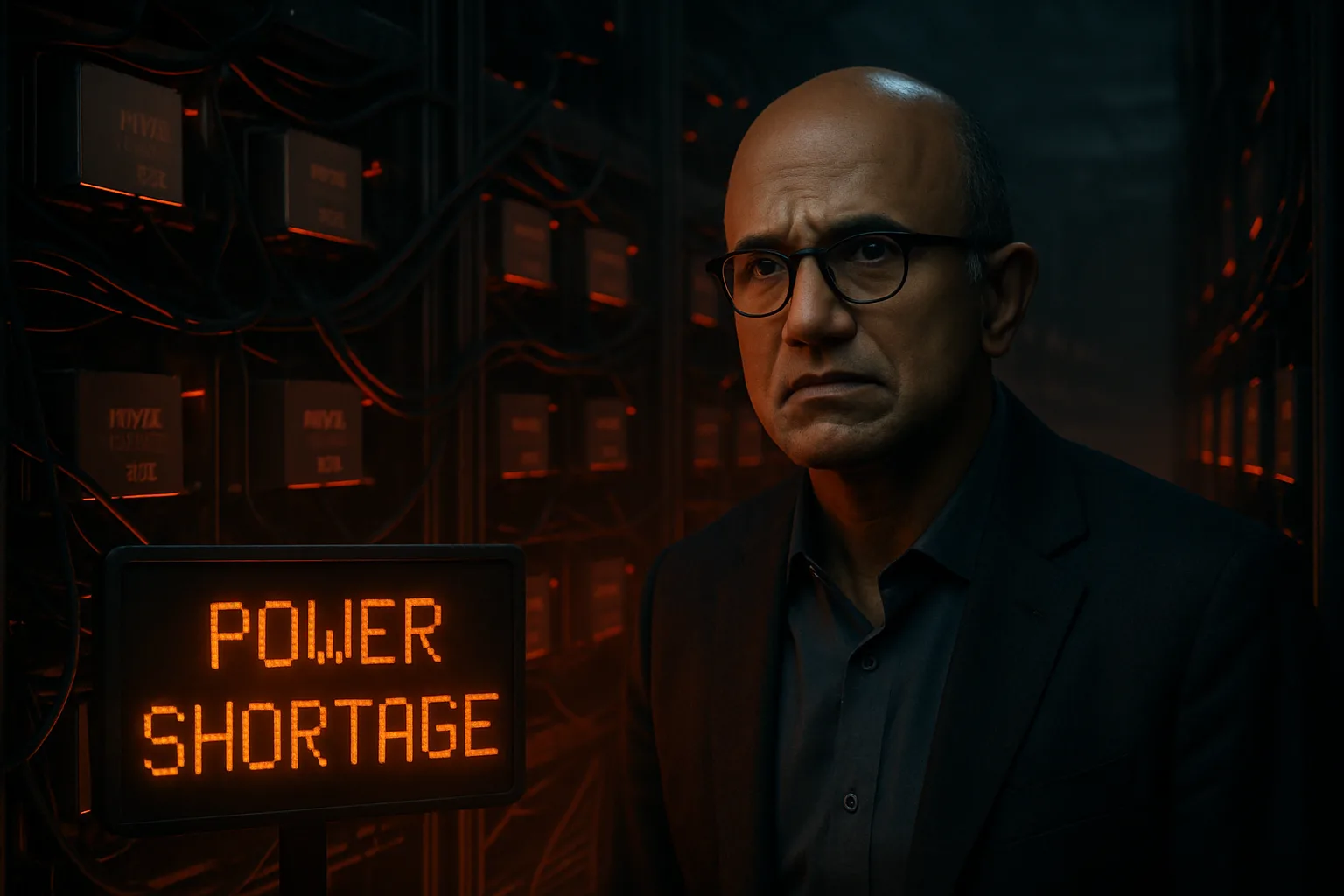

O CEO da Microsoft, Satya Nadella, fez uma revelação surpreendente que lança uma luz sobre um dos maiores desafios da corrida pela Inteligência Artificial: a Energia para GPUs de IA. Em uma entrevista recente, Nadella admitiu que a gigante da tecnologia está enfrentando uma escassez crítica de capacidade energética para alimentar o vasto inventário de unidades de processamento gráfico (GPUs) que a empresa adquiriu para seus data centers. A declaração sugere que o gargalo da inovação em IA não é mais a produção de chips, mas sim a infraestrutura básica de energia.

A fala de Nadella, durante uma conversa com Sam Altman (CEO da OpenAI), desvia o foco da narrativa comum de escassez de hardware, dominada pela NVIDIA. Segundo o executivo, a Microsoft possui chips em estoque que simplesmente não podem ser conectados à rede. “O maior problema que estamos tendo agora não é um excesso de compute, mas sim a energia – é a capacidade de construir [data centers] rápido o suficiente perto da energia”, afirmou o CEO, destacando que a empresa tem “um monte de chips parados em inventário que não consigo ligar”.

O Verdadeiro Gargalo da Inteligência Artificial: A Crise de Energia para Data Centers

A demanda por Energia para GPUs de IA e data centers tem crescido exponencialmente, superando a capacidade das concessionárias de energia de fornecer eletricidade de forma rápida e sustentável. Este problema não é exclusivo da Microsoft, mas a admissão de Nadella, uma figura central na revolução da IA, sublinha a gravidade da situação. A construção de novos data centers, que consomem o equivalente a pequenas cidades, está sendo atrasada pela dificuldade em garantir o fornecimento de energia necessário.

A corrida armamentista da IA, impulsionada por empresas como Microsoft, Google e Amazon, exige investimentos maciços em infraestrutura. No entanto, a necessidade de energia está forçando as empresas a repensarem suas estratégias de localização e construção. A China, por exemplo, tem sido citada como um país com vantagem na corrida de IA devido aos seus investimentos maciços em fontes de energia como hidrelétricas e nucleares, que podem suportar a alta demanda de seus próprios data centers.

Como a escassez de energia pode afetar o futuro da IA no Brasil?

Embora a crise de energia seja mais evidente nos grandes centros de tecnologia, ela tem implicações diretas para o mercado brasileiro. A infraestrutura de cloud computing, da qual muitas empresas brasileiras dependem, é alimentada por esses data centers globais. A limitação na expansão dos data centers da Microsoft e de outras gigantes pode resultar em custos mais altos e menor disponibilidade de recursos de IA avançados para o Brasil.

Além disso, a discussão sobre a necessidade de mais energia renovável e sustentável para a IA ganha força. A OpenAI, parceira da Microsoft, já pediu ao governo americano para investir na construção de 100 gigawatts de capacidade de geração de energia anualmente, reconhecendo que a energia é um ativo estratégico na competição global de IA. A longo prazo, a solução para a crise de Energia para GPUs de IA pode envolver um foco maior em modelos de IA mais eficientes e em dispositivos de consumo capazes de rodar modelos localmente, reduzindo a dependência dos data centers centralizados.

“Se você não pode fazer isso, você pode realmente ter um monte de chips parados em inventário que eu não consigo ligar. Na verdade, esse é o meu problema hoje. Não é uma questão de fornecimento de chips; é o fato de que eu não tenho ‘warm shells’ para conectar.” – Satya Nadella, CEO da Microsoft.

A revelação de Satya Nadella serve como um alerta para a indústria de tecnologia: a próxima fronteira da IA não será definida apenas por quem tem os melhores chips, mas por quem tem a energia para mantê-los funcionando. Este é um desafio que exigirá inovação não apenas em software e hardware, mas também em infraestrutura energética global.

Para mais informações sobre o impacto da IA na infraestrutura global, confira nosso artigo sobre o crescimento explosivo dos data centers.