O Google Cloud anunciou a disponibilidade geral do seu mais novo processador de inteligência artificial, o **Ironwood TPU** de sétima geração, juntamente com as novas máquinas virtuais (VMs) baseadas em Arm, chamadas **Axion**. Este lançamento marca um movimento estratégico do Google para consolidar sua plataforma como o principal “AI Hypercomputer”, oferecendo uma infraestrutura co-otimizada de hardware e software para a crescente demanda da era da inferência de IA.

A transição do foco do treinamento para a inferência de modelos de IA, que é a fase de aplicação prática, exige um novo nível de eficiência e latência. O Ironwood TPU foi projetado especificamente para atender a essa demanda, prometendo um salto significativo de desempenho em relação às gerações anteriores e reforçando a competição direta com as soluções da Nvidia no mercado de chips de IA.

Ironwood TPU: 10x Mais Desempenho para a Inferência de IA

O Ironwood, a sétima geração do Tensor Processing Unit (TPU) do Google, é a peça central desta nova arquitetura. Ele foi construído com o propósito de lidar com as cargas de trabalho mais exigentes, desde o treinamento de modelos em larga escala e aprendizado por reforço complexo até a inferência de IA de alto volume e baixa latência. O Google afirma que o Ironwood oferece uma melhoria de desempenho de pico de **10 vezes** em relação ao TPU v5p.

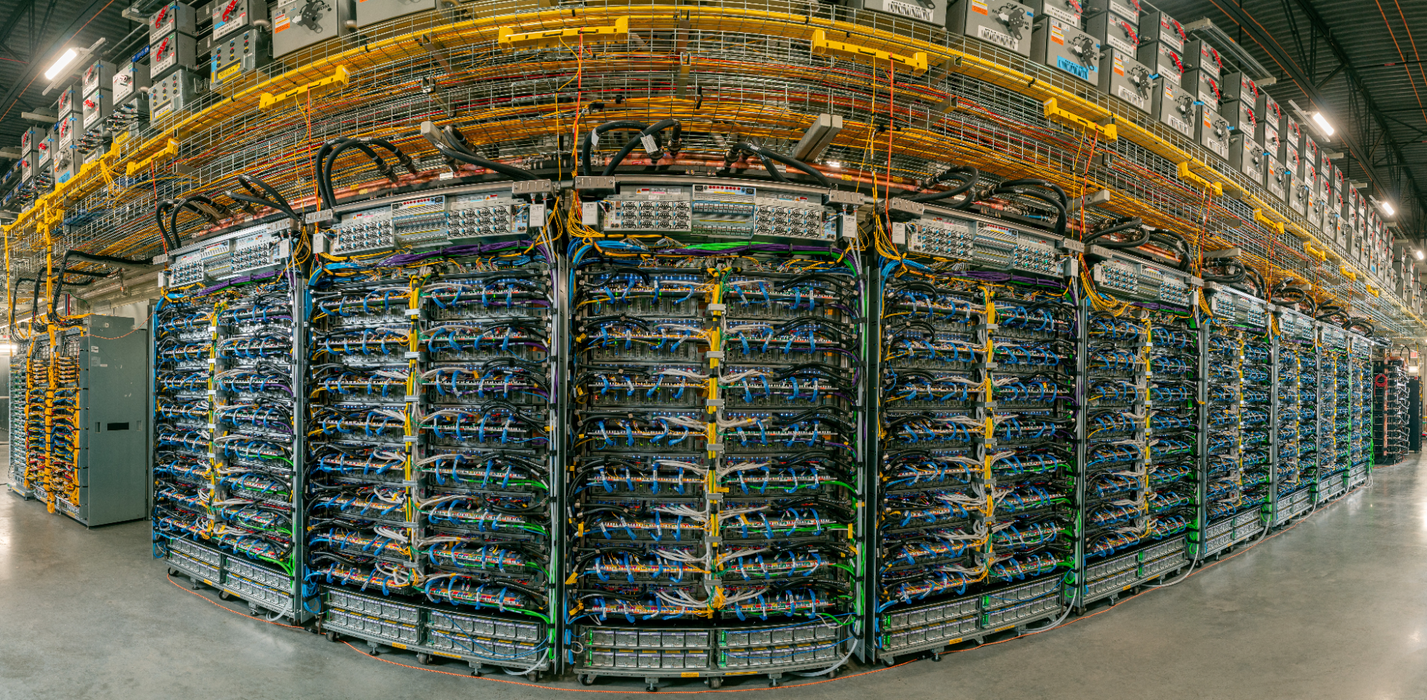

Além do ganho de velocidade, o Ironwood é o chip personalizado mais poderoso e com maior eficiência energética do Google até o momento. Essa eficiência é crucial, especialmente para clientes como a Anthropic, que já manifestou interesse em acessar até 1 milhão de TPUs para acelerar a transição do treinamento de seus modelos Claude para o serviço a milhões de usuários. A capacidade de escalar é impressionante, com o Ironwood permitindo a criação de “superpods” com até **9.216 chips** interconectados por uma rede ICI (Inter-Chip Interconnect) de 9,6 Tb/s, acessando 1,77 Petabytes de memória HBM compartilhada.

Como o Axion CPU Complementa a Estratégia do Google Cloud?

Junto com o Ironwood TPU, o Google está expandindo seu portfólio de computação com as novas instâncias baseadas em Arm, o **Axion CPU**. As novas VMs N4A, que já estão em pré-visualização, são destacadas como as máquinas virtuais da série N mais econômicas do Google Cloud, oferecendo até **2x melhor preço-desempenho** em comparação com VMs x86 de geração atual. Essa é uma resposta clara à crescente adoção de arquiteturas Arm em data centers e à necessidade de CPUs de propósito geral eficientes para orquestrar e coordenar os fluxos de trabalho de IA.

A introdução do Axion C4A metal, a primeira instância bare metal baseada em Arm do Google, que será lançada em breve, reforça a visão de um “AI Hypercomputer”. Neste modelo, o Google co-projeta hardware e software, desde o silício até a camada de aplicação, para maximizar o desempenho e a eficiência. A coordenação entre os Axion CPUs (para tarefas gerais e orquestração) e os Ironwood TPUs (para aceleração de ML) é fundamental para a performance em fluxos de trabalho de agentes de IA.

Quais os Benefícios do AI Hypercomputer para Empresas no Brasil?

Para empresas e startups no Brasil que buscam implementar ou escalar soluções de inteligência artificial, a arquitetura AI Hypercomputer do Google Cloud representa uma oportunidade de otimização de custos e performance. A promessa de 353% de ROI em três anos e 28% menos custos de TI, conforme um relatório recente da IDC, é um forte indicativo do potencial de eficiência que essa infraestrutura integrada pode oferecer. A disponibilidade geral do Ironwood e a pré-visualização do Axion N4A nas próximas semanas significam que a tecnologia de ponta para a era da inferência estará acessível para impulsionar a inovação local.

A otimização de software, com recursos como o Cluster Director no Google Kubernetes Engine e melhorias no framework MaxText, também facilita a adoção e o gerenciamento de grandes clusters de TPUs. Isso permite que as equipes de engenharia se concentrem em acelerar os avanços em IA, em vez de gerenciar complexidades de infraestrutura. A integração com ferramentas populares como o vLLM, que permite aos desenvolvedores alternar entre GPUs e TPUs, garante flexibilidade e um caminho de migração mais suave para quem já utiliza outras soluções.

“Nossos clientes, de empresas Fortune 500 a startups, dependem do Claude para seus trabalhos mais críticos. À medida que a demanda continua a crescer exponencialmente, estamos aumentando nossos recursos de computação. As melhorias do Ironwood tanto no desempenho de inferência quanto na escalabilidade de treinamento nos ajudarão a escalar de forma eficiente, mantendo a velocidade e a confiabilidade que nossos clientes esperam.” – James Bradbury, Head of Compute, Anthropic.

O Google Cloud está claramente investindo pesado em silício personalizado para se diferenciar no mercado de infraestrutura de IA. Com o Ironwood TPU e o Axion CPU, a empresa não apenas oferece alternativas poderosas aos chips da Nvidia, mas também apresenta uma visão de futuro onde o hardware e o software são co-desenhados para criar um ecossistema de supercomputação otimizado para a próxima geração de modelos de IA e fluxos de trabalho de agentes.

Para saber mais sobre a arquitetura e os detalhes técnicos do Ironwood e Axion, a fonte primária para este anúncio é o blog oficial do Google Cloud. Acompanhe o IntrigaBits para mais análises sobre a corrida do hardware de inteligência artificial.