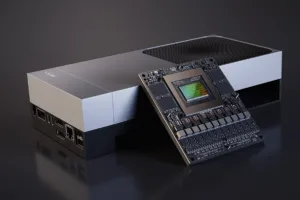

A Google acaba de intensificar a corrida por hardware de inteligência artificial (IA) com o lançamento do seu mais novo e poderoso processador: o Ironwood TPU. Este chip, a sétima geração da Unidade de Processamento Tensorial (TPU) da empresa, está sendo disponibilizado para clientes do Google Cloud, marcando um avanço significativo na capacidade de treinar e executar modelos de IA em larga escala. O Ironwood promete um desempenho até dez vezes superior ao de seu antecessor, o TPU v5p, consolidando a estratégia da Google de dominar a pilha completa de IA, do silício ao software.

A novidade chega em um momento crucial, onde a demanda por poder computacional para IA atinge picos históricos. Ao oferecer o Ironwood, a Google não apenas desafia a hegemonia da Nvidia no mercado de GPUs, mas também fornece aos seus clientes de nuvem uma alternativa altamente otimizada para cargas de trabalho intensivas. A arquitetura do novo chip foi projetada para eficiência e escala, permitindo a criação de “superpods” massivos, capazes de interligar milhares de chips em uma rede de alta velocidade.

O Ironwood já está sendo adotado por grandes nomes da indústria de IA, como a Anthropic, que utiliza a infraestrutura do Google Cloud para desenvolver seus modelos de linguagem. Este movimento demonstra a confiança do mercado na solução integrada da Google, que combina hardware proprietário com a plataforma de nuvem e modelos de ponta como o Gemini. A Google aposta que o controle total sobre o design do chip e do software resultará em custos operacionais mais baixos e maior eficiência energética para seus clientes.

O que torna o Ironwood TPU um divisor de águas na IA?

O grande diferencial do Ironwood TPU reside em seu salto de performance e na sua capacidade de escala. O chip oferece um aumento de até 10 vezes na taxa de transferência (throughput) em comparação com a geração anterior. Além disso, ele foi projetado para se conectar em uma arquitetura de “superpod” que pode abrigar até 9.216 chips, todos interligados por uma rede de 9,6 terabits por segundo e compartilhando quase 1,8 petabytes de memória HBM (High Bandwidth Memory).

Essa capacidade de interconexão massiva é essencial para o treinamento de modelos de IA cada vez maiores e mais complexos, como o Gemini. A Google também implementou tecnologias avançadas de resfriamento líquido e comutação óptica para garantir a estabilidade e a eficiência energética do sistema em tal escala. A otimização conjunta de hardware e software é a chave para o sucesso do Ironwood, permitindo que a Google ofereça uma solução de IA de ponta a ponta que é difícil de ser replicada por concorrentes que dependem de hardware de terceiros.

Como o Ironwood se posiciona frente à concorrência de chips de IA?

O lançamento do Ironwood é uma resposta direta à intensa competição no mercado de aceleradores de IA, dominado pela Nvidia. No entanto, a Google não está sozinha na busca por alternativas. Gigantes como Amazon Web Services (AWS) com seus chips Trainium e Inferentia, e a Microsoft Azure com o Maia 100 (parte do Projeto Athena), também estão investindo pesadamente em silício customizado. A Meta, por sua vez, desenvolveu o MTIA para inferência e está testando um chip de treinamento.

A diferença fundamental é que a Google, com o Ironwood, está oferecendo uma solução totalmente integrada, desde o chip até o modelo de IA (Gemini), passando pela infraestrutura de nuvem. Essa verticalização permite um nível de otimização que se traduz em benefícios econômicos para os clientes. A Google afirma que a demanda por sua infraestrutura de IA, incluindo as soluções baseadas em TPU, tem sido um motor de crescimento significativo para o Google Cloud, com a empresa fechando mais de US$ 1 bilhão em contratos de nuvem neste ano, superando os dois anos anteriores combinados.

Qual o impacto do Ironwood para o futuro da inteligência artificial no Brasil?

A disponibilização de chips de alto desempenho como o Ironwood TPU no Google Cloud tem um impacto direto no desenvolvimento e na adoção de IA no Brasil. Empresas e startups brasileiras que utilizam a nuvem para treinar seus modelos de IA agora terão acesso a uma infraestrutura mais rápida e eficiente. Isso pode acelerar a inovação em setores como finanças, agronegócio e saúde, permitindo que modelos de IA sejam desenvolvidos e implementados mais rapidamente e a um custo mais competitivo.

A Google Cloud já possui uma forte presença no Brasil, e a inclusão do Ironwood em sua oferta global significa que o poder de processamento de ponta estará acessível localmente. O aumento da performance e a redução de custos por treinamento são fatores cruciais para democratizar o acesso à IA avançada, permitindo que mais empresas brasileiras explorem o potencial de modelos de linguagem grandes (LLMs) e outras aplicações de aprendizado de máquina. Este é um passo importante para garantir que o Brasil não fique para trás na revolução global da inteligência artificial.

O Ironwood TPU não é apenas um novo chip; é um componente central na estratégia da Google para se consolidar como líder na era da IA, oferecendo a seus clientes a capacidade de processamento necessária para construir o futuro da tecnologia.

Para saber mais sobre a estratégia de IA da Google e o impacto de seus chips, confira nosso artigo sobre como o modelo Gemini está redefinindo a busca e a nuvem.

**Fonte:** Google Cloud, Yahoo Finance, TheStreet. **Data de Disponibilidade:** O Ironwood TPU estará disponível para o público nas próximas semanas.