O Google revelou recentemente as medidas de segurança que serão implementadas para proteger os usuários contra os riscos inerentes aos novos recursos de inteligência artificial (IA) “agentic” do Chrome. Estes recursos, que permitem ao navegador realizar ações complexas em nome do usuário, como agendar compromissos ou fazer compras, exigem uma camada extra de proteção para evitar fraudes e vazamento de dados. A Segurança Chrome IA é a resposta da gigante de buscas para garantir que a automação não se torne uma vulnerabilidade.

A introdução de agentes de IA nos navegadores marca uma nova era na interação online, mas também abre portas para novos vetores de ataque. Por isso, o Google está focando em modelos de observação e consentimento explícito do usuário para manter as ações da IA sob controle. A principal inovação é o uso de modelos de IA especializados para fiscalizar o comportamento do agente, garantindo que ele opere dentro dos limites de segurança definidos.

Como o Google Garante a Segurança dos Recursos Agentic?

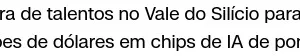

Para mitigar os riscos, o Google desenvolveu o conceito de Agent Origin Sets, que restringe o acesso do modelo de IA a conjuntos de dados e domínios específicos. Essa abordagem divide as origens da web em dois tipos: “read-only” (somente leitura) e “read-writeable” (leitura e escrita). Isso significa que o agente só pode consumir informações de fontes permitidas e só pode interagir (clicar ou digitar) em áreas específicas de páginas autorizadas, como campos de formulário relevantes, e não em anúncios ou iframes não relacionados.

Outra camada de proteção é o “User Alignment Critic”, um modelo de IA baseado no Gemini que atua como um fiscal. Ele examina as ações planejadas pelo agente antes que sejam executadas. Se o “Critic” determinar que a ação não está alinhada com o objetivo do usuário ou apresenta risco, ele instrui o agente a repensar a estratégia. É importante notar que o Critic só analisa os metadados da ação, e não o conteúdo real da web, preservando a privacidade.

Quando o Agente de IA Pede Permissão ao Usuário?

O Google estabeleceu que o controle final deve sempre estar nas mãos do usuário, especialmente em tarefas sensíveis. O navegador pedirá permissão explícita em três cenários principais:

- Navegação para Sites Sensíveis: Antes de acessar páginas que contenham informações bancárias, médicas ou dados pessoais, o agente solicitará a aprovação do usuário.

- Uso de Credenciais: Para sites que exigem login, o Chrome pedirá permissão para usar o gerenciador de senhas, garantindo que o modelo de IA não tenha acesso direto aos dados de senha.

- Ações Transacionais: Qualquer ação que envolva transações financeiras, como fazer uma compra, ou comunicação, como enviar uma mensagem, será submetida ao consentimento do usuário.

Além disso, o Google está utilizando um classificador de “prompt-injection” para prevenir que comandos maliciosos sejam inseridos no agente, e está testando ativamente as capacidades “agentic” contra ataques criados por pesquisadores de segurança. Essas medidas demonstram um esforço contínuo para integrar a IA de forma segura no dia a dia dos usuários do Chrome, garantindo que a conveniência da automação não comprometa a Segurança Chrome IA.

A implementação desses recursos de segurança é crucial para a adoção em massa dos agentes de IA nos navegadores. O Google, ao detalhar publicamente suas salvaguardas, busca construir a confiança necessária para que os usuários se sintam seguros ao delegar tarefas complexas ao Gemini no Chrome. A expectativa é que essas funcionalidades sejam lançadas nos próximos meses, começando pelos Estados Unidos.

Para mais detalhes técnicos sobre a implementação, você pode consultar o artigo original no TechCrunch aqui e o blog post oficial do Google sobre os novos recursos de IA no Chrome.