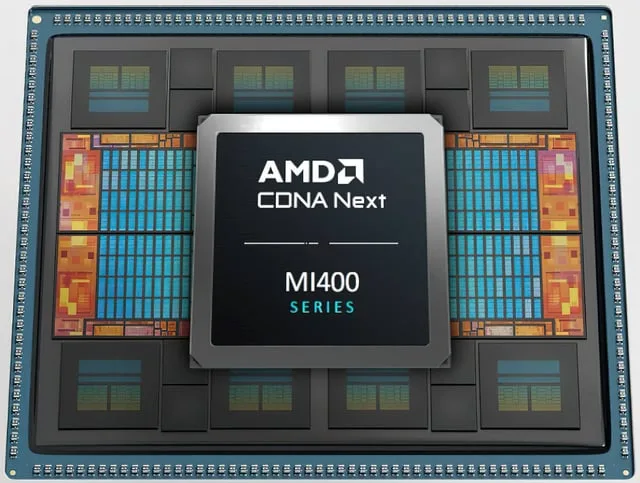

A Advanced Micro Devices (AMD) está pronta para redefinir o cenário da inteligência artificial (IA) com o anúncio de sua estratégia para chips e sistemas de IA, que será detalhada hoje, 11 de novembro de 2025, durante o seu Dia do Analista Financeiro (Financial Analyst Day) em Nova York. O foco principal está na próxima geração de aceleradores, a série AMD MI400, projetada para desafiar a hegemonia da Nvidia no mercado de data centers.

Este evento é crucial para a AMD, que busca capitalizar o explosivo crescimento do mercado de IA. A empresa, já consolidada no segmento de CPUs contra a Intel, agora mira o topo da cadeia de valor da IA, onde a Nvidia domina com seus produtos de alto desempenho. A expectativa é que a AMD apresente não apenas os novos chips, mas também uma visão completa de seu ecossistema de hardware e software.

O que esperar da nova geração de chips AMD MI400?

A série AMD MI400 de chips de IA está programada para ser lançada em 2026. Fontes indicam que esta nova linha incluirá diversas variantes otimizadas tanto para aplicações científicas de ponta quanto para a crescente demanda por IA generativa. O objetivo é oferecer um salto de desempenho que justifique a migração de grandes clientes de data centers.

Além dos chips, a AMD planeja introduzir um rack de servidor completo, um sistema integrado que rivalizará diretamente com o produto GB200 NVL72 da Nvidia. Essa abordagem de “solução completa” é vital para simplificar a implementação de infraestruturas de IA em larga escala, oferecendo aos clientes uma alternativa coesa e de alto desempenho.

Qual o impacto do chip AMD MI400 no mercado brasileiro?

O lançamento da série MI400 tem um potencial significativo para o mercado brasileiro. Com a crescente adoção de IA em setores como finanças, agronegócio e saúde no Brasil, a chegada de um concorrente de peso para a Nvidia pode levar a uma maior competitividade de preços e a uma diversificação das opções de hardware. Isso é fundamental para que empresas brasileiras possam escalar suas operações de IA de forma mais acessível e eficiente.

A estratégia da AMD de oferecer soluções de rack completas também facilita a adoção por provedores de nuvem e grandes corporações locais, que buscam infraestruturas prontas para uso. O investimento em IA no Brasil está em ascensão, e ter mais de um fornecedor de tecnologia de ponta é um fator de aceleração para a inovação nacional.

A Parceria Estratégica com a OpenAI

Um ponto de destaque na estratégia da AMD é a parceria de longo prazo firmada com a OpenAI, criadora do ChatGPT. Este acordo, anunciado em outubro, é projetado para gerar mais de US$ 100 bilhões em novas receitas para a AMD ao longo de quatro anos, provenientes da OpenAI e de outros clientes. Como parte do arranjo, a OpenAI receberá warrants que lhe permitirão adquirir até 10% de participação na fabricante de chips.

Essa colaboração garante à AMD um cliente de peso e uma validação de sua tecnologia no campo da IA generativa, um segmento dominado pela OpenAI. O acordo é um passo fundamental para a AMD capturar uma fatia maior do boom de gastos com IA, que até então tem beneficiado desproporcionalmente sua principal rival.

Acompanhe o IntrigaBits para mais detalhes sobre os anúncios do Financial Analyst Day da AMD, que promete ser um marco na corrida dos chips de IA.

Para saber mais sobre a estratégia da AMD no mercado de data centers, confira nosso artigo anterior sobre o crescimento da AMD no segmento de data center.

Fontes: Reuters, AMD Investor Relations