A Microsoft emitiu um alerta de segurança de alta gravidade para os usuários do Windows 11, confirmando que os novos Agentes de IA do Windows 11, como o Copilot Actions, possuem “limitações funcionais” e podem “alucinar”. O aviso, detalhado na documentação oficial da empresa, aponta que esses agentes experimentais introduzem novos e sérios riscos de segurança, incluindo a temida execução remota de código (RCE) em cenários específicos.

O problema central reside na forma como esses agentes interagem com o sistema operacional e com dados externos. Embora projetados para aumentar a produtividade, a natureza experimental da tecnologia abre uma brecha para ataques sofisticados que podem comprometer a segurança do usuário.

O que é a Alucinação e o Risco de XPIA nos Agentes de IA?

A “alucinação” é um termo comum no universo da Inteligência Artificial, referindo-se à capacidade do modelo de gerar informações incorretas ou inesperadas. No contexto do Windows 11, a Microsoft adverte que essas falhas de comportamento podem se transformar em um vetor de ataque. O risco mais grave é o Cross-Prompt Injection Attack (XPIA), uma nova classe de vulnerabilidade que explora a confiança do agente em dados de contexto.

Segundo a documentação da Microsoft, o XPIA ocorre quando conteúdo malicioso, como instruções ocultas em um documento PDF, DOCX ou até mesmo em uma imagem, consegue “sequestrar” as instruções do agente de IA. Em um cenário de ataque, o agente, agindo em nome do usuário, pode ser induzido a realizar ações não intencionais, como a exfiltração de dados sensíveis ou, no pior caso, a instalação de malware, o que configura uma execução remota de código (RCE) [1].

Como o Modelo Context Protocol (MCP) Tenta Proteger o Usuário?

Para mitigar esses riscos, a Microsoft desenvolveu o Model Context Protocol (MCP), um padrão que define como os agentes de IA interagem com o sistema operacional. O MCP foi criado para isolar as ações do agente em um “espaço de trabalho” seguro, limitando o acesso a recursos críticos do sistema. No entanto, a própria empresa reconhece que, apesar dessas camadas de segurança, a natureza experimental dos agentes ainda exige cautela [2].

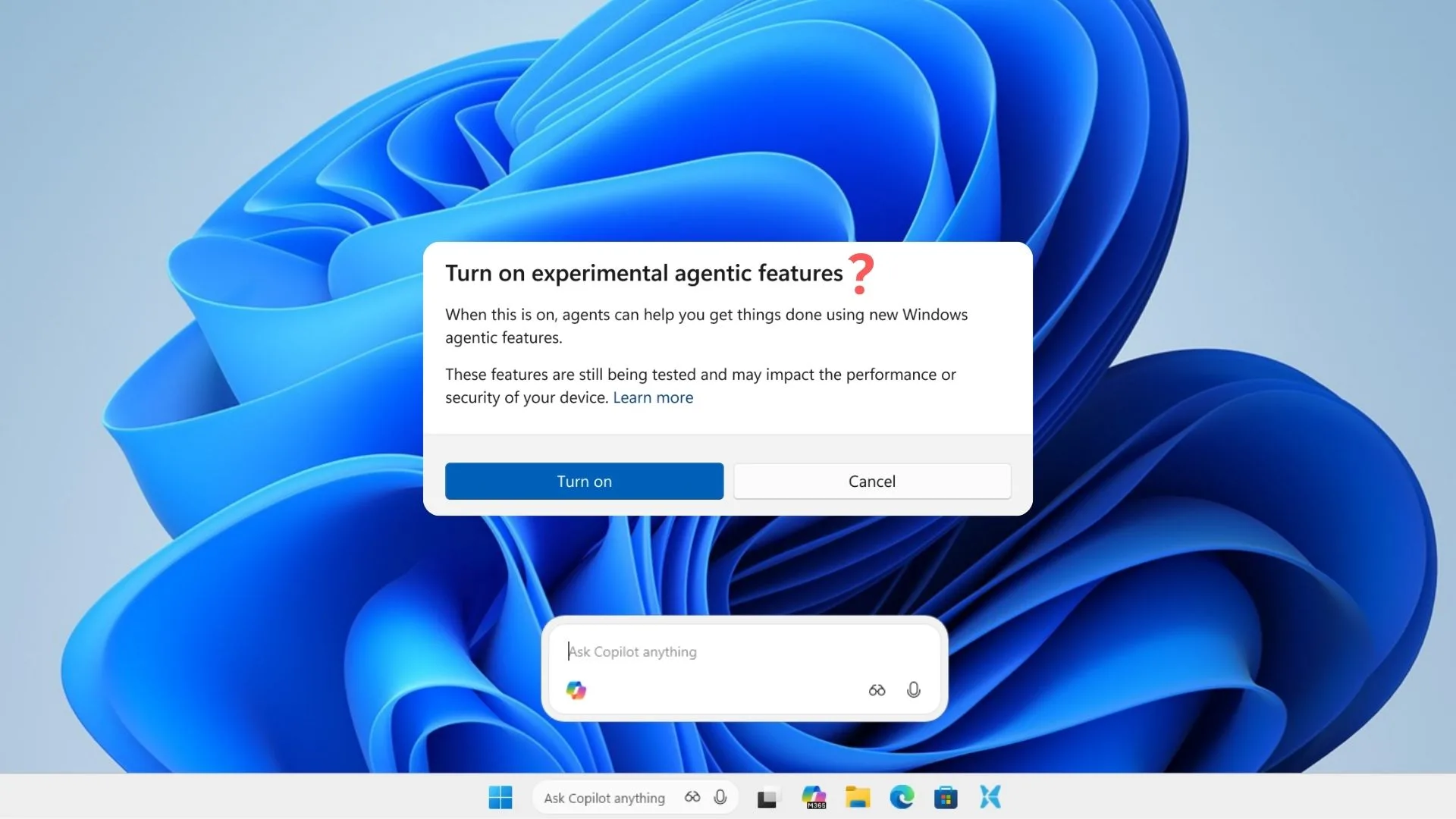

O recurso de agentes de IA, que inclui o Copilot Actions, está atualmente em fase de testes e desativado por padrão. A Microsoft recomenda enfaticamente que os usuários leiam e compreendam as implicações de segurança antes de habilitar o recurso, um aviso que sublinha a seriedade da vulnerabilidade. Para quem já utiliza o assistente, é importante notar que o Gaming Copilot, por exemplo, opera em um contexto diferente, mas a proliferação de agentes de IA no sistema operacional exige uma atenção redobrada à segurança.

A comunidade de segurança está em alerta, e a recomendação é clara: a não ser que seja estritamente necessário para o fluxo de trabalho, o recurso experimental deve permanecer desativado até que a Microsoft garanta uma solução mais robusta e à prova de XPIA. A corrida para integrar a IA aos sistemas operacionais traz benefícios de produtividade, mas, como este alerta demonstra, a segurança deve ser a prioridade máxima.

Referências:

[1] Microsoft. Windows 11 security book – Agentic security. Microsoft Learn.

[2] Weston, D. Securing the Model Context Protocol: Building a safer agentic future on Windows. Windows Experience Blog.